Robotlar txt ga o'xshaydi. Robotlar txt faylini o'rnatish bo'yicha tavsiyalar

Har bir blogda bunga o'z javobi bor. Shuning uchun, qidiruv tizimini reklama qilish uchun yangi kelganlar ko'pincha chalkashib ketishadi, masalan:

Qanday robotlar ti ex ti?

Fayl robots.txt yoki indeks fayli- http, https va FTP protokollari uchun amal qiluvchi UTF-8 kodlashdagi oddiy matn hujjati. Fayl qidiruv robotlariga tavsiyalar beradi: qaysi sahifalar/fayllarni skanerlash kerak. Agar faylda kodlashda UTF-8 dan boshqa belgilar mavjud bo'lsa, qidiruv robotlari ularni noto'g'ri qayta ishlashi mumkin. robots.txt faylida keltirilgan qoidalar faqat fayl joylashgan xost, protokol va port raqami uchun amal qiladi.

Fayl oddiy matnli hujjat sifatida ildiz katalogida joylashgan bo'lishi va quyidagi manzilda mavjud bo'lishi kerak: https://site.com.ua/robots.txt.

Boshqa fayllarda BOM (Bayte Order Mark) belgilash odatiy holdir. Bu ma'lumotni o'qishda bayt ketma-ketligini aniqlash uchun ishlatiladigan Unicode belgisi. Uning kod belgisi U+FEFF. robots.txt faylining boshida bayt ketma-ketligi belgisi e'tiborga olinmaydi.

Google robots.txt fayli uchun o'lcham chegarasini o'rnatdi - uning og'irligi 500 KB dan oshmasligi kerak.

Yaxshi, agar siz faqat texnik tafsilotlarga qiziqsangiz, robots.txt fayli Backus-Naur (BNF) shaklidagi tavsifdir. Bu RFC 822 qoidalaridan foydalanadi.

Robots.txt faylidagi qoidalarni qayta ishlashda qidiruv robotlari uchta ko'rsatmalardan birini oladi:

- qisman kirish: alohida veb-sayt elementlarini skanerlash mavjud;

- to'liq kirish: siz hamma narsani skanerlashingiz mumkin;

- to'liq taqiq: robot hech narsani skanerlay olmaydi.

robots.txt faylini skanerlashda robotlar quyidagi javoblarni oladi:

- 2xx - skanerlash muvaffaqiyatli bo'ldi;

- 3xx - qidiruv roboti boshqa javob olguncha yo'naltirishni kuzatib boradi. Ko'pincha robotning 3xx dan boshqa javob olishiga beshta urinish bor, keyin 404 xatosi qayd etiladi;

- 4xx - qidiruv roboti saytning butun mazmunini skanerlash mumkin deb hisoblaydi;

- 5xx - vaqtinchalik server xatolari sifatida baholanadi, skanerlash butunlay taqiqlanadi. Robot boshqa javob olguncha faylga kira oladi Google qidiruv roboti saytdagi etishmayotgan sahifalar javobi to'g'ri yoki noto'g'ri sozlanganligini aniqlashi mumkin, ya'ni 404 xato o'rniga sahifa 5xx javob qaytarsa. bu holda sahifa 404 javob kodi bilan qayta ishlanadi.

Robots.txt fayli qanday qayta ishlanayotgani hozircha ma'lum emas, bu internetga kirish bilan bog'liq server muammolari tufayli unga kirish imkoni yo'q.

Nima uchun sizga robots.txt fayli kerak?

Masalan, ba'zida robotlar tashrif buyurmasligi kerak:

- saytdagi foydalanuvchilarning shaxsiy ma'lumotlari bo'lgan sahifalar;

- ma'lumotni yuborish uchun turli shakllarga ega sahifalar;

- oyna saytlari;

- qidiruv natijalari sahifalari.

Muhim: agar sahifa robots.txt faylida bo'lsa ham, agar unga havola sayt ichida yoki tashqi manbada topilgan bo'lsa, u natijalarda paydo bo'lishi ehtimoli bor.

Qidiruv tizimi robotlari robots.txt fayli bo'lgan va bo'lmagan saytni shunday ko'radi:

Robots.txtsiz, qiziquvchan ko'zlardan yashirilishi kerak bo'lgan ma'lumotlar qidiruv natijalarida paydo bo'lishi mumkin va bu tufayli siz ham, sayt ham zarar ko'rasiz.

Qidiruv tizimi roboti robots.txt faylini shunday ko'radi:

Google saytdagi robots.txt faylini aniqladi va sayt sahifalarini skanerlash qoidalarini topdi.

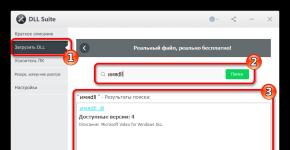

robots.txt faylini qanday yaratish mumkin

Bloknot, Notepad, Sublime yoki boshqa matn muharriridan foydalanish.

Foydalanuvchi-agent - robotlar uchun tashrif qog'ozi

User-agent - robots.txt faylida tasvirlangan ko'rsatmalarni qaysi robotlar ko'rishi kerakligi haqidagi qoida. Hozirda 302 ta qidiruv robotlari ma'lum

Unda aytilishicha, biz barcha qidiruv robotlari uchun robots.txt-da qoidalarni belgilaymiz.

Google uchun asosiy robot Googlebot hisoblanadi. Agar biz faqat buni hisobga olmoqchi bo'lsak, fayldagi yozuv quyidagicha bo'ladi:

Bunday holda, barcha boshqa robotlar bo'sh robots.txt faylini qayta ishlash bo'yicha o'z ko'rsatmalari asosida tarkibni skanerlaydi.

Yandex uchun asosiy robot... Yandex:

Boshqa maxsus robotlar:

- Googlebot-News— yangiliklarni qidirish;

- Mediapartners-Google— AdSense xizmati uchun;

- AdsBot-Google— ochilish sahifasining sifatini tekshirish;

- Yandex rasmlari— Yandex.Rasmlar indeksi;

- Googlebot-Image- rasmlar uchun;

- YandexMetrika— Yandex.Metrica roboti;

- YandexMedia— multimedia maʼlumotlarini indekslovchi robot;

- YaDirectFetcher— Yandex.Direct roboti;

- Googlebot-Video- video uchun;

- Googlebot-Mobile- mobil versiya uchun;

- YandexDirectDyn— dinamik banner yaratish roboti;

- YandexBloglar— xabarlar va sharhlarni indekslaydigan blog qidiruv roboti;

- YandexMarket— Yandex.Market roboti;

- Yandex News— Yandex.News roboti;

- YandexDirect— reklama tarmogʻining hamkor saytlarining mazmuni haqidagi maʼlumotlarni tegishli reklamani tanlash uchun mavzularini aniqlashtirish maqsadida yuklab oladi;

- Yandex sahifa tekshiruvi— mikro belgilash validatori;

- Yandex kalendar— Yandex.Calendar roboti.

Ruxsat bermaslik - "g'ishtlarni" joylashtirish

Agar sayt takomillashtirilayotgan bo'lsa va siz uning hozirgi holatida qidiruv natijalarida ko'rinishini xohlamasangiz, undan foydalanishga arziydi.

Sayt foydalanuvchilarga ko'rishga tayyor bo'lishi bilanoq ushbu qoidani olib tashlash muhimdir. Afsuski, ko'plab veb-ustalar buni unutishadi.

Misol. Robotlarga jildning mazmunini ko'rmaslikni maslahat berish uchun Ruxsat bermaslik qoidasini qanday o'rnatish kerak /papka/:

Bu qator .gif kengaytmali barcha fayllarni indekslashni taqiqlaydi

Ruxsat bering - biz robotlarni boshqaramiz

Ruxsat berish har qanday fayl/direktiv/sahifani skanerlash imkonini beradi. Aytaylik, siz robotlar faqat /katalog bilan boshlanadigan sahifalarni ko'rishini va boshqa barcha kontentni yopishini xohlaysiz. Bunday holda, quyidagi kombinatsiya buyuriladi:

Ruxsat berish va taqiqlash qoidalari URL prefiksi uzunligi (eng kichikdan kattagacha) bo‘yicha saralanadi va ketma-ket qo‘llaniladi. Agar sahifaga bir nechta qoida mos kelsa, robot tartiblangan roʻyxatdagi oxirgi qoidani tanlaydi.

Xost - oyna saytini tanlang

Xost - bu robots.txt uchun majburiy qoidalardan biri, u Yandex robotiga saytning qaysi ko'zgularini indekslash uchun e'tiborga olish kerakligini aytadi.

Sayt oynasi - bu turli manzillarda mavjud bo'lgan saytning aniq yoki deyarli aniq nusxasi.

Robot sayt oynalarini topishda adashmaydi va asosiy oyna robots.txt faylida ko'rsatilganligini tushunadi. Sayt manzili "http://" prefiksisiz ko'rsatilgan, lekin agar sayt HTTPS da ishlayotgan bo'lsa, "https://" prefiksi ko'rsatilishi kerak.

Ushbu qoidani qanday yozish kerak:

Agar sayt HTTPS protokolida ishlayotgan bo'lsa, robots.txt fayliga misol:

Sayt xaritasi - tibbiy sayt xaritasi

Sayt xaritasi robotlarga indekslash uchun zarur bo'lgan barcha sayt URL manzillari joylashganligini aytadi http://site.ua/sitemap.xml. Har bir skanerlashda robot ushbu faylga qanday o'zgarishlar kiritilganligini ko'rib chiqadi va qidiruv tizimining ma'lumotlar bazalarida sayt haqidagi ma'lumotlarni tezda yangilaydi.

Crawl-delay - zaif serverlar uchun sekundomer

Crawl-delay - bu sayt sahifalari yuklanadigan vaqtni belgilash uchun ishlatilishi mumkin bo'lgan parametr. Agar sizda zaif server bo'lsa, bu qoida tegishli. Bunday holda, qidiruv robotlari sayt sahifalariga kirishda uzoq kechikishlar bo'lishi mumkin. Ushbu parametr soniyalarda o'lchanadi.

Clean-param - dublikat kontent ovchisi

Clean-param turli dinamik manzillarda (savol belgilari bilan) mavjud bo'lishi mumkin bo'lgan kontentning takrorlanishini oldini olish uchun parametrlarni olish bilan shug'ullanishga yordam beradi. Bunday manzillar, agar saytda turli xil saralashlar, sessiya identifikatorlari va boshqalar bo'lsa, paydo bo'ladi.

Aytaylik, sahifa quyidagi manzillarda mavjud:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

Bunday holda, robots.txt fayli quyidagicha ko'rinadi:

Bu yerga ref havola qayerdan kelganligini ko'rsatadi, shuning uchun u eng boshida yoziladi va shundan keyingina manzilning qolgan qismi ko'rsatiladi.

Ammo ma'lumotnoma fayliga o'tishdan oldin, siz hali ham robots.txt faylini yozishda ishlatiladigan ba'zi belgilar bilan tanishishingiz kerak.

robots.txt-dagi belgilar

Faylning asosiy belgilari "/, *, $, #".

Yordamida slash "/" biz o'zimizni robotlar tomonidan aniqlashdan himoya qilmoqchi ekanligimizni ko'rsatamiz. Misol uchun, "Ruxsat bermaslik" qoidasida bitta chiziq bo'lsa, biz butun saytni skanerlashni taqiqlaymiz. Ikki slash belgisidan foydalanib, ma'lum bir katalogni skanerlashni oldini olishingiz mumkin, masalan: /catalog/.

Ushbu yozuvda aytilishicha, biz katalog papkasining butun tarkibini skanerlashni taqiqlaymiz, lekin agar biz /katalog deb yozsak, saytdagi /katalog bilan boshlanadigan barcha havolalarni taqiqlaymiz.

Yulduzcha "*" fayldagi har qanday belgilar ketma-ketligini bildiradi. Har bir qoidadan keyin joylashtiriladi.

Ushbu yozuvda aytilishicha, barcha robotlar /catalog/ jildida .gif kengaytmali fayllarni indekslamasligi kerak.

Dollar belgisi «$» yulduzcha belgisi harakatlarini cheklaydi. Agar siz katalog papkasining butun mazmunini bloklashni xohlasangiz, lekin /katalogni o'z ichiga olgan URL manzillarini bloklay olmasangiz, indeks faylidagi yozuv quyidagicha bo'ladi:

"#" katakchasi vebmaster o'zi yoki boshqa veb-ustalar uchun qoldiradigan sharhlar uchun ishlatiladi. Saytni skanerlashda robot ularni hisobga olmaydi.

Masalan:

Ideal robots.txt qanday ko'rinadi

Fayl indekslash uchun sayt tarkibini ochadi, xost ro'yxatga olinadi va sayt xaritasi ko'rsatiladi, bu qidiruv tizimlariga har doim indekslanishi kerak bo'lgan manzillarni ko'rish imkonini beradi. Yandex uchun qoidalar alohida ko'rsatilgan, chunki hamma robotlar Xost ko'rsatmalarini tushunmaydi.

Ammo fayl mazmunini o'zingizga nusxalashga shoshilmang - har bir sayt sayt va CMS turiga bog'liq bo'lgan o'ziga xos qoidalarga ega bo'lishi kerak. Shuning uchun, robots.txt faylini to'ldirishda barcha qoidalarni esga olish kerak.

Robots.txt faylingizni qanday tekshirish mumkin

Agar siz robots.txt fayli to'g'ri to'ldirilganligini bilmoqchi bo'lsangiz, uni veb-master asboblarida tekshiring Google va Yandex. Robots.txt faylining manba kodini havola orqali shaklga kiriting va tekshiriladigan saytni belgilang.

robots.txt faylini qanday to'ldirmaslik kerak

Ko'pincha, indeks faylini to'ldirishda zerikarli xatolarga yo'l qo'yiladi va ular oddiy e'tiborsizlik yoki shoshqaloqlik bilan bog'liq. Quyida men amalda duch kelgan xatolar jadvali keltirilgan.

2. Bitta Disallow bayonotida bir nechta papkalar/kataloglarni yozish:

Bunday yozuv qidiruv robotlarini chalkashtirib yuborishi mumkin, ular aniq nimani indekslamasliklari kerak: birinchi yoki oxirgi papka, shuning uchun har bir qoidani alohida yozishingiz kerak;

3. Faylning o'zi chaqirilishi kerak faqat robots.txt, va Robots.txt, ROBOTS.TXT yoki boshqa hech narsa emas.

4. User-agent qoidasini bo'sh qoldira olmaysiz - faylda yozilgan qoidalarni qaysi robot hisobga olishi kerakligini aytishingiz kerak.

5. Fayldagi qo'shimcha belgilar (qiyshiq chiziq, yulduzcha).

6. Indeksda bo'lmasligi kerak bo'lgan sahifalarni faylga qo'shish.

robots.txt dan nostandart foydalanish

To'g'ridan-to'g'ri funktsiyalardan tashqari, indeks fayli ijodkorlik platformasi va yangi xodimlarni topish usuliga aylanishi mumkin.

Bu yerda robots.txt ning o'zi ishlaydigan elementlar va hatto reklama birligi bo'lgan kichik sayt bo'lgan sayt.

Fayl asosan SEO agentliklari tomonidan mutaxassislarni qidirish platformasi sifatida ishlatiladi. Uning mavjudligi haqida yana kim bilishi mumkin? :)

Va Google maxsus faylga ega humans.txt, shuning uchun siz teri va go'sht bo'yicha mutaxassislarni kamsitish haqida o'ylashga ruxsat bermaysiz.

xulosalar

Robots.txt yordamida siz robotlarni qidirish, o'zingizni, brendingizni reklama qilish va mutaxassislarni qidirish bo'yicha ko'rsatmalar berishingiz mumkin. Bu tajriba uchun ajoyib maydon. Asosiysi, faylni to'g'ri to'ldirish va odatiy xatolar haqida eslash.

Qoidalar, shuningdek, direktivlar sifatida ham tanilgan, robots.txt faylidagi ko'rsatmalar sifatida ham tanilgan:

- Foydalanuvchi-agent - robots.txt da tasvirlangan ko'rsatmalarni qaysi robotlar ko'rishi kerakligi haqidagi qoida.

- Disallow qaysi ma'lumotlarni skanerdan o'tkazmaslik haqida tavsiyalar beradi.

- Sayt xaritasi robotlarga indekslash uchun zarur bo'lgan barcha sayt URL manzillari http://site.ua/sitemap.xml manzilida joylashganligini aytadi.

- Xost Yandex robotiga indekslash uchun sayt oynalaridan qaysi biri e'tiborga olinishi kerakligini aytadi.

- Ruxsat berish har qanday fayl/direktiv/sahifani skanerlash imkonini beradi.

Robots.txt ni kompilyatsiya qilishdagi belgilar:

- Dollar belgisi "$" yulduz belgisining harakatlarini cheklaydi.

- “/” chizig‘idan foydalanib, biz uni robotlar tomonidan aniqlashdan yashirishni xohlayotganimizni bildiramiz.

- Yulduzcha "*" fayldagi har qanday belgilar ketma-ketligini bildiradi. Har bir qoidadan keyin joylashtiriladi.

- "#" xeshi veb-ustaning o'zi yoki boshqa veb-ustalar uchun yozgan sharhlarini ko'rsatish uchun ishlatiladi.

Indeks faylidan oqilona foydalaning - va sayt har doim qidiruv natijalarida bo'ladi.

Bu ish bo'yicha ko'rsatmalar talab qiladi qidiruv tizimlari qoidadan istisno emas, shuning uchun ular maxsus fayl deb nomlangan robots.txt. Ushbu fayl saytingizning asosiy papkasida joylashgan bo'lishi kerak yoki u virtual bo'lishi mumkin, ammo so'rov bo'yicha ochilishi kerak: www.yoursite.ru/robots.txt

Qidiruv mexanizmlari uzoq vaqtdan beri kerakli html fayllarini CMS tizimingizning ichki skriptlari to'plamidan ajratishni o'rgandilar, aniqrog'i, ular kontent maqolalari va har xil axlatlarga havolalarni tanib olishni o'rgandilar. Shuning uchun, ko'plab veb-ustalar allaqachon o'z saytlari uchun robotlar qilishni unutib qo'yishadi va baribir hamma narsa yaxshi bo'ladi deb o'ylashadi. Ha, ular 99% to'g'ri, chunki agar sizning saytingizda ushbu fayl bo'lmasa, qidiruv tizimlari kontentni qidirishda cheksizdir, ammo xatolarni oldindan hal qilish mumkin bo'lgan nuanslar mavjud.

Saytda ushbu fayl bilan bog'liq muammolar mavjud bo'lsa, ushbu maqolaga sharhlar yozing va men sizga bu borada tezda yordam beraman, mutlaqo bepul. Ko'pincha veb-ustalar unda kichik xatolarga yo'l qo'yishadi, bu esa saytni yomon indeksatsiya qilish yoki hatto indeksdan chiqarib tashlashga olib keladi.

robots.txt nima uchun?

robots.txt fayli qidiruv tizimlari tomonidan saytni to'g'ri indekslashni sozlash uchun yaratilgan. Ya'ni, u sizning saytingiz yoki kontent turining muayyan yo'llari bo'yicha ruxsatlar va taqiqlar qoidalarini o'z ichiga oladi. Ammo bu panatseya emas. Hammasi robotlar faylidagi qoidalar ko'rsatmalar emas ularga aniq amal qiling, lekin shunchaki qidiruv tizimlari uchun tavsiya. Masalan, Google yozadi:

Google Qidiruv natijalaridan sahifani yashirish uchun robots.txt faylidan foydalana olmaysiz. Boshqa sahifalar unga bog'lanishi mumkin va u hali ham indekslanadi.

Qidiruv robotlari nimani indekslash va nima qilish kerakligi va saytda o'zini qanday tutish kerakligini o'zlari hal qilishadi. Har bir qidiruv tizimining o'z vazifalari va funktsiyalari mavjud. Qanchalik xohlamasak ham, bu ularni bo'ysundirishning bir usuli emas.

Ammo ushbu maqolaning mavzusi bilan bevosita bog'liq bo'lmagan bitta hiyla bor. Robotlar qidiruv natijalarida sahifani indekslash va ko'rsatishni to'liq oldini olish uchun quyidagilarni yozishingiz kerak:

Keling, robotlarga qaytaylik. Ushbu fayldagi qoidalar quyidagi turdagi fayllarga kirishni bloklashi yoki ruxsat berishi mumkin:

- Grafik bo'lmagan fayllar. Asosan, bu ba'zi ma'lumotlarni o'z ichiga olgan html fayllari. Ikki nusxadagi sahifalarni yoki foydali ma'lumot bermaydigan sahifalarni yopishingiz mumkin (sahifalash sahifalari, kalendar sahifalari, arxiv sahifalari, profil sahifalari va boshqalar).

- Grafik fayllar. Agar siz sayt tasvirlari qidiruvlarda ko'rsatilmasligini istasangiz, buni robotlarda o'rnatishingiz mumkin.

- Resurs fayllari. Shuningdek, robotlardan foydalanib, siz turli xil skriptlarni, CSS uslubidagi fayllarni va boshqa ahamiyatsiz resurslarni indekslashni bloklashingiz mumkin. Ammo siz tashrif buyuruvchilar uchun saytning vizual qismi uchun javobgar bo'lgan resurslarni bloklamasligingiz kerak (masalan, agar siz chiroyli bloklar yoki jadvallarni ko'rsatadigan saytning CSS va JS-ni yopsangiz, qidiruv roboti buni ko'rmaydi va shikoyat qiladi. u).

Robotlar qanday ishlashini aniq ko'rsatish uchun quyidagi rasmga qarang:

Qidiruv roboti saytga ergashib, indekslash qoidalarini ko'rib chiqadi, so'ngra fayl tavsiyalariga muvofiq indekslashni boshlaydi.  Qoida sozlamalariga qarab, qidiruv tizimi nimani indekslash mumkinligini va nima bo'lmasligini biladi.

Qoida sozlamalariga qarab, qidiruv tizimi nimani indekslash mumkinligini va nima bo'lmasligini biladi.

robots.txt fayl intax dan

Qidiruv tizimlari uchun qoidalarni yozish uchun robotlar faylida turli parametrlarga ega direktivalar qo'llaniladi, ularning yordami bilan robotlar amal qiladi. Birinchi va, ehtimol, eng muhim ko'rsatma bilan boshlaylik:

Foydalanuvchi-agent direktivasi

Foydalanuvchi-agent— Ushbu direktiva bilan siz fayldagi tavsiyalardan foydalanishi kerak bo'lgan robot nomini ko'rsatasiz. Internet olamida rasman 302 ta robot mavjud. Albatta, siz har bir kishi uchun qoidalarni alohida yozishingiz mumkin, ammo bunga vaqtingiz bo'lmasa, shunchaki yozing:

Foydalanuvchi-agent: *

*-bu misolda "Hammasi" degan ma'noni anglatadi. Bular. robots.txt faylingiz "aniq kimga" mo'ljallanganligi bilan boshlanishi kerak. Robotlarning barcha nomlari bilan bezovta qilmaslik uchun foydalanuvchi-agent direktivasiga "yulduzcha" yozing.

Men sizga mashhur qidiruv tizimlarining robotlarining batafsil ro'yxatini beraman:

Google - Googlebot- asosiy robot

Boshqa Google robotlariGooglebot-News— yangiliklarni qidirish roboti

Googlebot-Image- robot rasmlari

Googlebot-Video— robot video

Googlebot-Mobile— robotning mobil versiyasi

AdsBot-Google— ochilish sahifasi sifatini tekshirish roboti

Mediapartners-Google— AdSense xizmati roboti

Yandex - YandexBot- asosiy indekslash roboti;

Boshqa Yandex robotlariYo'l qo'ymaslik va ruxsat berish ko'rsatmalari

Ruxsat bermaslik- robotlardagi eng asosiy qoida, aynan shu direktiv yordamida siz saytingizdagi ba'zi joylarni indekslashni taqiqlaysiz. Direktiv quyidagicha yozilgan:

Ruxsat bermaslik:

Juda tez-tez ruxsat berish direktivasini ko'rishingiz mumkin: bo'sh, ya'ni. go'yoki robotga saytda hech narsa taqiqlanmaganligini aytib, xohlagan narsani indekslang. Diqqatli bo'ling! Agar siz ruxsat bermaslik / qo'ysangiz, saytni indeksatsiyadan butunlay yopasiz.

Shuning uchun, robots.txt ning eng standart versiyasi "barcha qidiruv tizimlari uchun butun saytni indekslash imkonini beradi" quyidagicha ko'rinadi:

Foydalanuvchi-Agent: * Ruxsat bermaslik:

Agar siz robots.txt da nima yozishni bilmasangiz, lekin bu haqda biror joyda eshitgan bo'lsangiz, shunchaki yuqoridagi koddan nusxa oling, uni robots.txt nomli faylga saqlang va saytingiz ildiziga yuklang. Yoki hech narsa yaratmang, chunki usiz ham robotlar saytingizdagi hamma narsani indekslaydi. Yoki maqolani oxirigacha o'qing va siz saytda nimani yopish kerakligini va nima bo'lmasligini tushunasiz.

Robotlar qoidalariga ko'ra, taqiqlash direktivasi talab qilinishi kerak.

Ushbu ko'rsatma jildni ham, alohida faylni ham taqiqlashi mumkin.

Agar Siz hohlasangiz papkani taqiqlash yozishingiz kerak:

Ruxsat bermaslik: /papka/

Agar Siz hohlasangiz muayyan faylni taqiqlash:

Ruxsat bermaslik: /images/img.jpg

Agar Siz hohlasangiz muayyan fayl turlarini taqiqlash:

Ruxsat bermaslik: /*.png$

Oddiy iboralar ko'plab qidiruv tizimlari tomonidan qo'llab-quvvatlanmaydi. Google qo'llab-quvvatlaydi.

Ruxsat bering— Robots.txt da direktivaga ruxsat berish. Bu robotga taqiqlangan katalogdagi ma'lum bir yo'l yoki faylni indekslash imkonini beradi. Yaqin vaqtgacha u faqat Yandex tomonidan ishlatilgan. Google buni ushladi va undan ham foydalanishni boshladi. Masalan:

Ruxsat berish: /kontent Ruxsat bermaslik: /

Ushbu direktivalar kontent papkasidan tashqari barcha sayt tarkibini indekslanishiga yo'l qo'ymaydi. Yoki so'nggi paytlarda boshqa mashhur ko'rsatmalar:

Ruxsat berish: /template/*.js Ruxsat berish: /template/*.css Ruxsat berish: /shablon

bu qadriyatlar saytdagi barcha CSS va JS fayllarini indekslashga ruxsat bering, lekin ular shabloningiz bilan papkadagi hamma narsani indekslashga ruxsat bermaydi. O'tgan yil davomida Google veb-ustalar uchun quyidagi mazmundagi ko'plab xatlarni yubordi:

Googlebot saytdagi CSS va JS fayllariga kira olmaydi

Va tegishli izoh: Saytingiz bilan bog‘liq muammo aniqlandi, bu uning tekshirilishiga to‘sqinlik qilishi mumkin. robots.txt faylidagi cheklovlar tufayli Googlebot JavaScript kodini va/yoki CSS fayllarini qayta ishlay olmaydi. Ushbu ma'lumotlar saytning ishlashini baholash uchun kerak. Shuning uchun, agar resurslarga kirish bloklangan bo'lsa, bu sizning saytingizning Qidiruvdagi o'rnini yomonlashtirishi mumkin..

Agar Robots.txt-ga oxirgi kodda yozilgan ikkita ruxsat berish direktivasini qo'shsangiz, Google'dan shunga o'xshash xabarlarni ko'rmaysiz.

Va robots.txt da maxsus belgilardan foydalanish

Endi direktivadagi belgilar haqida. Buni taqiqlash yoki ruxsat berishdagi asosiy belgilar (maxsus belgilar) /,*,$

Toʻgʻri chiziq “/” haqida

Robots.txt da slash juda aldamchi. Men bir necha o'nlab marta qiziq vaziyatni kuzatganman, o'z bilmasligimdan robots.txt-ga quyidagilar qo'shilgan:

Foydalanuvchi-Agent: * Ruxsat bermaslik: /

Chunki ular qayerdandir sayt tuzilishi haqida o'qib, o'z saytida ko'chirib olishgan. Ammo bu holda siz butun saytni indekslashni taqiqlash. Muayyan katalogni barcha ichki ma'lumotlar bilan indekslashni taqiqlash uchun siz oxiriga / qo'yishingiz kerak. Agar siz, masalan, Disallow: /seo deb yozsangiz, saytingizdagi seo so'zini o'z ichiga olgan mutlaqo barcha havolalar indekslanmaydi. Garchi u papka /seo/ bo'lsa ham, kategoriya bo'lsa ham /seo-tool/, maqola /seo-best-of-the-best-soft.html bo'lsa ham, bularning barchasi bo'lmaydi. indekslanadi.

Hamma narsani diqqat bilan ko'rib chiqing / robots.txt faylida

Har doim kataloglarning oxiriga / qo'ying. Agar siz "Ruxsat bermaslik" ni qo'ysangiz, butun saytni indekslanishiga yo'l qo'ymaysiz, lekin "Ruxsat berish" ni qo'ymasangiz, butun saytni indekslanishiga ham to'sqinlik qilasiz. / - qaysidir ma'noda "Ko'rsatmalarga amal qiladigan hamma narsa /" degan ma'noni anglatadi.

Yulduzchalar haqida * robots.txt

Maxsus belgi * har qanday (shu jumladan bo'sh) belgilar ketma-ketligini bildiradi. Siz uni robotlarning istalgan joyida quyidagi kabi ishlatishingiz mumkin:

Foydalanuvchi-agent: * Ruxsat bermaslik: /papka/*.aspx Ruxsat bermaslik: /*old

Papka katalogidagi aspx kengaytmali barcha fayllarni taqiqlaydi va nafaqat /eski papkani, balki /papka/old direktivasini ham taqiqlaydi. Ayyormi? Shuning uchun robotlaringizda * belgisi bilan o'ynashni tavsiya etmayman.

Birlamchi in indekslash va taqiqlash qoidalari fayli robots.txt barcha direktivalarda *!

$ maxsus belgi haqida

Robotlardagi maxsus $ belgisi * maxsus belgining ta'sirini tugatadi. Masalan:

Ruxsat bermaslik: /menu$

Ushbu qoida "/menu" ni taqiqlaydi, lekin "/menu.html" ni taqiqlamaydi, ya'ni. Fayl qidiruv tizimlarini faqat /menu direktivasidan taqiqlaydi va URLda so'z menyusi bo'lgan barcha fayllarni taqiqlay olmaydi.

Xost direktivasi

Xost qoidasi faqat Yandex-da ishlaydi, shuning uchun ixtiyoriy, agar mavjud bo'lsa, u saytingiz oynalaridan asosiy domenni aniqlaydi. Masalan, sizda dom.com domeningiz bor, lekin quyidagi domenlar ham sotib olingan va sozlangan: dom2.com, dom3,com, dom4.com va ulardan dom.com asosiy domeniga yo'naltirish mavjud.

Yandex qaysi biri asosiy sayt (xost) ekanligini tezda aniqlashi uchun robots.txt-ga xost katalogini yozing:

Xost: veb-sayt

Agar sizning saytingizda oynalar bo'lmasa, unda siz ushbu qoidani o'rnatishingiz shart emas. Lekin birinchi navbatda, saytingizni IP manzili bo'yicha tekshiring, ehtimol sizning asosiy sahifangiz undan ochiladi va siz asosiy oynani ro'yxatdan o'tkazishingiz kerak. Yoki kimdir saytingizdagi barcha ma'lumotlarni ko'chirib olib, aniq nusxasini yaratgan bo'lishi mumkin, agar u ham o'g'irlangan bo'lsa, robots.txt-dagi yozuv bu sizga yordam beradi.

Bitta xost yozuvi bo'lishi kerak va agar kerak bo'lsa, ro'yxatdan o'tgan port bilan. (Xost: sayt: 8080)

Tekshirishni kechiktirish bo'yicha ko'rsatma

Ushbu direktiva serveringizga yuklanish ehtimolini yo'qotish uchun yaratilgan. Qidiruv tizimi botlari bir vaqtning o'zida saytingizga yuzlab so'rovlar yuborishi mumkin va agar serveringiz zaif bo'lsa, bu kichik xatolarga olib kelishi mumkin. Buning oldini olish uchun biz skanerlash-kechiktiruvchi robotlar uchun qoidani ishlab chiqdik - bu sizning saytingizga sahifani yuklash orasidagi minimal davr. Ushbu ko'rsatma uchun standart qiymatni 2 soniyaga o'rnatish tavsiya etiladi. Robotlarda bu shunday ko'rinadi:

Tekshirish kechikishi: 2

Ushbu direktiv Yandex uchun ishlaydi. Google-da siz skanerlash chastotasini webmaster panelida, Sayt sozlamalari bo'limida, yuqori o'ng burchakda "tishli" bilan belgilashingiz mumkin.

Clean-param direktivasi

Bu parametr faqat Yandex uchun ham. Agar sayt sahifasi manzillarida ularning mazmuniga ta'sir qilmaydigan dinamik parametrlar mavjud bo'lsa (masalan: seans identifikatorlari, foydalanuvchilar, refererlar va boshqalar), siz ularni Clean-param direktivasi yordamida tavsiflashingiz mumkin.

Ushbu ma'lumotlardan foydalangan holda, Yandex roboti takroriy ma'lumotlarni qayta yuklamaydi. Bu sizning saytingizni skanerlash samaradorligini oshiradi va serverdagi yukni kamaytiradi.

Masalan, saytda quyidagi sahifalar mavjud:

www.site.com/some_dir/get_book.pl?ref=site_1&book_id=123

Parametr ref faqat so'rov qaysi manbadan qilinganligini kuzatish uchun ishlatiladi va kitobning mazmunini o'zgartirmaydi book_id=123 uchta manzilda ko'rsatiladi; Keyin, agar siz direktivani quyidagicha belgilasangiz:

Foydalanuvchi-agent: Yandex taqiqlash: Clean-param: ref /some_dir/get_book.pl

Yandex roboti barcha sahifa manzillarini bittaga qisqartiradi:

www.site.com/some_dir/get_book.pl?ref=site_1&book_id=123,

Agar saytda parametrlarsiz sahifa mavjud bo'lsa:

www.site.com/some_dir/get_book.pl?book_id=123

keyin robot tomonidan indekslanganida hamma narsa unga tushadi. Saytingizdagi boshqa sahifalar tez-tez tekshiriladi, chunki sahifalarni yangilash shart emas:

www.site.com/some_dir/get_book.pl?ref=site_2&book_id=123

www.site.com/some_dir/get_book.pl?ref=site_3&book_id=123

#kabi manzillar uchun: www.site1.com/forum/showthread.php?s=681498b9648949605&t=8243 www.site1.com/forum/showthread.php?s=1e71c4427317a117a&t=8243a foydalanuvchisi:bot #ro bo'ladi: Yandex taqiqlash: Clean-param: s /forum/showthread.php

Sayt xaritasi direktivasi

Ushbu direktiva bilan siz shunchaki sitemap.xml manzilini belgilaysiz. Robot buni eslab qoladi, "rahmat" aytadi va uni berilgan yo'l bo'ylab doimiy ravishda tahlil qiladi. Bu shunday ko'rinadi:

Sayt xaritasi: http://site/sitemap.xml

Endi robotlarni yaratishda yuzaga keladigan umumiy savollarni ko'rib chiqamiz. Internetda bunday mavzular juda ko'p, shuning uchun biz eng dolzarb va eng keng tarqalganlarini tahlil qilamiz.

To'g'ri robots.txt

Bu so'zda juda ko'p "to'g'ri" mavjud, chunki bitta CMSda bitta sayt uchun bu to'g'ri bo'ladi, lekin boshqa CMSda u xatolarni keltirib chiqaradi. "To'g'ri tuzilgan" har bir sayt uchun individualdir. Robots.txt-da siz foydalanuvchilarga kerak bo'lmagan va qidiruv tizimlariga hech qanday qiymat bermaydigan bo'limlarni va fayllarni indekslashdan yopishingiz kerak. robots.txt ning eng oddiy va eng to'g'ri versiyasi

Foydalanuvchi-Agent: * Ruxsat bermaslik: Sayt xaritasi: http://site/sitemap.xml Foydalanuvchi-agent: Yandex Taqiqlash: Xost: site.com

Ushbu fayl quyidagi qoidalarni o'z ichiga oladi: barcha qidiruv tizimlari uchun taqiqlash qoidalarini sozlash (Foydalanuvchi-Agent: *), butun saytni indekslashga to'liq ruxsat berilgan ("Ruxsat bermaslik:" yoki "Ruxsat berish: /" ni belgilashingiz mumkin), xost Yandex uchun asosiy oyna ko'rsatilgan (Xost: site.ncom) va sayt xaritangiz.xml joylashuvi (Sayt xaritasi: .

WordPress uchun R obots.txt

Yana ko'p savollar bor, bitta sayt onlayn-do'kon, boshqasi blog, uchinchisi ochilish sahifasi, to'rtinchisi kompaniyaning tashrif qog'ozi sayti bo'lishi mumkin va bularning barchasi CMS WordPress-da bo'lishi mumkin va robotlar uchun qoidalar bo'lishi mumkin. butunlay boshqacha bo'ling. Bu blog uchun mening robots.txt faylim:

User-Agent: * Ruxsat berish: /wp-content/uploads/ Ruxsat berish: /wp-content/*.js$ Ruxsat berish: /wp-content/*.css$ Ruxsat berish: /wp-includes/*.js$ Ruxsat berish: / wp-includes/*.css$ Ruxsat berish: /wp-login.php Ruxsat berish: /wp-register.php Ruxsat berish: /xmlrpc.php Ruxsat berish: /template.html Ruxsat berish: /wp-admin Ruxsat berish: /wp-includes Ruxsat berish: /wp-content Ruxsat berish: /category Ruxsat berish: /arxiv Ruxsat berish: */trackback/ Ruxsat berish: */feed/ Ruxsat berish: /?feed= Ruxsat berish: /job Ruxsat berish: /?.net/sitemap.xml

Bu erda juda ko'p sozlamalar mavjud, keling, ularni birgalikda ko'rib chiqaylik.

WordPress-da ruxsat bering. Birinchi ruxsat beruvchi qoidalar foydalanuvchilarga kerak bo'lgan kontent (bular yuklanganlar jildidagi rasmlar) va robotlar (bu sahifalarni ko'rsatish uchun CSS va JS). Google tez-tez shikoyat qiladigan CSS va JS, shuning uchun biz ularni ochiq qoldirdik. “/*.css$” ni kiritish orqali barcha fayllar usulidan foydalanish mumkin edi, lekin aynan shu fayllar joylashgan papkalarni taqiqlovchi qator ularni indekslash uchun ishlatishga imkon bermadi, shuning uchun men yo‘lni ko‘rsatishim kerak edi. taqiqlovchi papkaga to'liq.

Ruxsat berish har doim “Ruxsat bermaslik”da taqiqlangan kontent yoʻliga ishora qiladi. Agar biror narsa sizga taqiqlanmagan bo'lsa, siz qidiruv tizimlariga turtki beryapsiz deb o'ylab, unga ruxsat yozmasligingiz kerak, masalan, "Kelinglar, bu sizga URL manzili, uni tezroq indekslang". Bu shunday ishlamaydi.

WordPress-da taqiqlash. WP CMS-da taqiqlanishi kerak bo'lgan juda ko'p narsalar mavjud. Ko'p turli xil plaginlar, juda ko'p turli xil sozlamalar va mavzular, ko'plab skriptlar va foydali ma'lumotlarni o'z ichiga olmaydigan turli xil sahifalar. Ammo men oldinga bordim va blogimdagi maqolalar (xabarlar) va sahifalar (muallif, xizmatlar haqida) bundan mustasno, hamma narsani indekslashni taqiqladim. Men hatto blogdagi toifalarni yopib qo'ydim, ularni so'rovlar uchun optimallashtirilganda va ularning har biri uchun matn tavsifi mavjud bo'lganda ochaman, ammo endi bu qidiruv tizimlariga kerak bo'lmagan takroriy postlarni oldindan ko'rishdir.

Xo'sh, Xost va Sayt xaritasi standart ko'rsatmalardir. Men faqat Yandex uchun xostni alohida qilishim kerak edi, lekin men bu haqda bezovta qilmadim. Endi biz WP uchun Robots.txt bilan yakunlaymiz.

robots.txt faylini qanday yaratish mumkin

Bu birinchi qarashda ko'rinadigan darajada qiyin emas. Siz shunchaki oddiy bloknotni (Notepad) olishingiz va ushbu maqoladagi sozlamalarga muvofiq saytingiz uchun ma'lumotlarni nusxalashingiz kerak. Ammo bu siz uchun qiyin bo'lsa, Internetda saytlaringiz uchun robotlar yaratishga imkon beruvchi resurslar mavjud:

Hech kim sizga bu o'rtoqlar kabi Robots.txt haqida ko'proq gapirmaydi. Axir, siz "taqiqlangan fayl" ni ular uchun yaratasiz.

Keling, robotlarda mavjud bo'lishi mumkin bo'lgan ba'zi bir kichik xatolar haqida gapiraylik.

- « Bo'sh qator" - foydalanuvchi-agent direktivasida bo'sh qator qo'yish mumkin emas.

- Da ziddiyat ikki o'rtasida direktivalar bir xil uzunlikdagi prefikslar bilan direktiva ustunlik qiladi Ruxsat bering.

- Har bir robots.txt fayli uchun qayta ishlanadi faqat bitta Xost direktivasi. Agar faylda bir nechta direktivalar ko'rsatilgan bo'lsa, robot birinchisidan foydalanadi.

- Direktiv Clean-Param ko'ndalang kesimli, shuning uchun uni robots.txt faylining istalgan joyida ko'rsatish mumkin. Agar bir nechta ko'rsatmalar ko'rsatilgan bo'lsa, ularning barchasi robot tomonidan hisobga olinadi.

- Oltita Yandex robotlari Robots.txt qoidalariga rioya qilmaydi (YaDirectFetcher, YandexCalendar, YandexDirect, YandexDirectDyn, YandexMobileBot, YandexAccessibilityBot). Ularning saytda indekslanishiga yo'l qo'ymaslik uchun ularning har biri uchun alohida foydalanuvchi-agent parametrlarini yaratishingiz kerak.

- Foydalanuvchi-agent direktivasi, har doim taqiqlovchi direktivaning ustiga yozilishi kerak.

- Bitta qator, bitta katalog uchun. Bir qatorga bir nechta kataloglarni yoza olmaysiz.

- Fayl nomi u faqat shunday bo'lishi kerak: robots.txt. Robots.txt, ROBOTS.txt va boshqalar yo'q. Sarlavhada faqat kichik harflar.

- Direktivda mezbon domenga yo'lni http va qiyshiq chiziqsiz yozishingiz kerak. Noto'g'ri: Xost: http://www.site.ru/, To'g'ri: Xost: www.site.ru

- Sayt xavfsiz protokoldan foydalanganda https direktivada mezbon(Yandeks roboti uchun) aniq protokolni ko'rsatish kerak, shuning uchun Xost: https://www.site.ru

Qiziqarli savollar va nuanslar paydo bo'lishi bilan ushbu maqola yangilanadi.

Men sen bilan edim, dangasa Staurus.

Sitemap.xml fayli va sayt uchun to'g'ri robots.txt - bu qidiruv robotlari tomonidan veb-resursning barcha kerakli sahifalarini tez va to'liq indekslashga hissa qo'shadigan ikkita majburiy hujjat. Yandex va Google-da saytlarni to'g'ri indekslash qidiruv tizimlarida blogni muvaffaqiyatli targ'ib qilishning kalitidir.

XML formatida sayt xaritasini qanday qilish kerakligini va nima uchun kerakligini allaqachon yozganman. Keling, WordPress sayti uchun to'g'ri robots.txt faylini qanday yaratish va umuman nima uchun kerakligi haqida gapiraylik. Ushbu fayl haqida batafsil ma'lumotni mos ravishda Yandex va Google'ning o'zidan olish mumkin. Men asosiyga o'taman va misol sifatida mening faylimdan foydalanib WordPress uchun asosiy robots.txt sozlamalariga tegaman.

Nima uchun veb-sayt uchun robots.txt fayli kerak?

robots.txt standarti 1994 yil yanvar oyida paydo bo'lgan. Veb-resursni skanerlashda qidiruv robotlari birinchi navbatda sayt yoki blogning ildiz papkasida joylashgan robots.txt matn faylini qidiradi. Uning yordami bilan biz turli xil qidiruv tizimlarining robotlari uchun saytni indekslaydigan ma'lum qoidalarni belgilashimiz mumkin.

Robots.txt faylini to'g'ri sozlash sizga quyidagilarga imkon beradi:

- dublikatlarni va turli keraksiz sahifalarni indeksdan chiqarib tashlash;

- biz yashirmoqchi bo'lgan sahifalar, fayllar va papkalarni indekslashni taqiqlash;

- odatda ba'zi qidiruv robotlariga indekslashni rad etish (masalan, Yahoo, raqobatchilardan kiruvchi havolalar haqidagi ma'lumotlarni yashirish uchun);

- saytning asosiy oynasini ko'rsating (www bilan yoki wwwsiz);

- sitemap.xml sayt xaritasiga yo'lni belgilang.

Sayt uchun to'g'ri robots.txt faylini qanday yaratish mumkin

Buning uchun maxsus generatorlar va plaginlar mavjud, ammo buni qo'lda qilish yaxshiroqdir.

Siz shunchaki har qanday matn muharriri (masalan, Notepad yoki Notepad++) yordamida robots.txt deb nomlangan oddiy matn faylini yaratishingiz va uni blogingizning ildiz papkasida joylashgan hostingingizga yuklashingiz kifoya. Ushbu faylda ma'lum direktivalar yozilishi kerak, ya'ni. Yandex, Google va boshqalar robotlari uchun indekslash qoidalari.

Agar siz bu bilan bezovtalanishga dangasa bo'lsangiz, quyida men o'z nuqtai nazarimdan, blogimdan WordPress uchun to'g'ri robots.txt-ga misol keltiraman. Domen nomini uchta joyga almashtirish orqali foydalanishingiz mumkin.

Robots.txt yaratish qoidalari va direktivalari

Blogni qidiruv tizimini muvaffaqiyatli optimallashtirish uchun siz robots.txt faylini yaratish qoidalarini bilishingiz kerak:

- Robots.txt faylining yo'qligi yoki bo'shligi qidiruv tizimlariga veb-resursning barcha mazmunini indekslashiga ruxsat berilganligini anglatadi.

- robots.txt saytingiz sayt.ru/robots.txt manzilida ochilishi kerak, robotga 200 OK javob kodini beradi va hajmi 32 KB dan oshmasligi kerak. Ochilmaydigan fayl (masalan, 404 xatosi tufayli) yoki kattaroq fayl yaxshi deb hisoblanadi.

- Fayldagi direktivalar soni 1024 dan oshmasligi kerak. Bitta qatorning uzunligi 1024 belgidan oshmasligi kerak.

- Yaroqli robots.txt fayli bir nechta bayonotga ega bo'lishi mumkin, ularning har biri User-agent direktivasi bilan boshlanishi va kamida bitta ruxsat berish direktivasiga ega bo'lishi kerak. Odatda ular Google va boshqa barcha robotlar va Yandex uchun alohida-alohida robots.txt da ko'rsatmalar yozadilar.

Asosiy robots.txt direktivalari:

Foydalanuvchi-agent - ko'rsatma qaysi qidiruv robotiga qaratilganligini ko'rsatadi.

“*” belgisi bu barcha robotlarga tegishli ekanligini bildiradi, masalan:

Foydalanuvchi-agent: *

Agar biz Yandex uchun robots.txt da qoida yaratishimiz kerak bo'lsa, biz yozamiz:

Foydalanuvchi-agent: Yandex

Agar ma'lum bir robot uchun direktiv belgilangan bo'lsa, User-agent: * direktivasi u tomonidan hisobga olinmaydi.

Ruxsat berish va ruxsat berish - mos ravishda robotlarga ko'rsatilgan sahifalarni indekslashni taqiqlash va ruxsat berish. Barcha manzillar saytning ildizidan ko'rsatilishi kerak, ya'ni. uchinchi chiziqdan boshlab. Masalan:

- Barcha robotlarga butun saytni indekslashni taqiqlash:

Foydalanuvchi-agent: *

Ruxsat bermaslik: / - Yandex-ga /wp-admin bilan boshlangan barcha sahifalarni indekslash taqiqlangan:

Foydalanuvchi-agent: Yandex

Ruxsat bermaslik: /wp-admin - Bo'sh Disallow direktivasi hamma narsani indekslash imkonini beradi va Ruxsat berish ga o'xshaydi. Masalan, men Yandex-ga butun saytni indekslashiga ruxsat beraman:

Foydalanuvchi-agent: Yandex

Ruxsat bermaslik: - Va aksincha, men barcha qidiruv robotlariga barcha sahifalarni indekslashni taqiqlayman:

Foydalanuvchi-agent: *

Ruxsat bering: - Xuddi shu User-agent blokidagi ruxsat berish va taqiqlash ko'rsatmalari URL prefiks uzunligi bo'yicha saralanadi va ketma-ket bajariladi. Agar saytning bir sahifasi uchun bir nechta direktivalar mos bo'lsa, ro'yxatdagi oxirgisi bajariladi. Endi robot direktivalardan foydalanganda ularni yozish tartibi muhim emas. Agar direktivada bir xil uzunlikdagi prefikslar bo'lsa, birinchi navbatda Allow bajariladi. Bunday qoidalar 2012 yil 8 martdan kuchga kirdi. Masalan, u faqat /wp-includes bilan boshlangan sahifalarni indekslash imkonini beradi:

Foydalanuvchi-agent: Yandex

Ruxsat bermaslik: /

Ruxsat bering: /wp-includes

Sayt xaritasi - XML sayt xaritasi manzilini belgilaydi. Bitta sayt bir nechta Sayt xaritasi ko'rsatmalariga ega bo'lishi mumkin, ularni joylashtirish mumkin. Saytni indekslashni tezlashtirish uchun barcha Sayt xaritasi fayl manzillari robots.txt da ko'rsatilishi kerak:

Sayt xaritasi: http://site/sitemap.xml.gz

Sayt xaritasi: http://site/sitemap.xml

Xost - oyna robotiga qaysi veb-sayt oynasi asosiysini ko'rib chiqish kerakligini aytadi.

Agar saytga bir nechta manzillardan kirish mumkin bo'lsa (masalan, www bilan va wwwsiz), bu filtr tomonidan ushlanishi mumkin bo'lgan to'liq dublikat sahifalarni yaratadi. Bundan tashqari, bu holda, bu indekslangan asosiy sahifa bo'lmasligi mumkin, lekin asosiy sahifa, aksincha, qidiruv tizimi indeksidan chiqarib tashlanadi. Buning oldini olish uchun robots.txt faylida faqat Yandex uchun mo'ljallangan va faqat bitta bo'lishi mumkin bo'lgan Xost direktivasidan foydalaning. U Disallow and Allow dan keyin yoziladi va quyidagicha ko'rinadi:

Xost: veb-sayt

Crawl-delay - sahifalarni yuklab olish o'rtasidagi kechikishni soniyalarda o'rnatadi. Og'ir yuk bo'lsa va server so'rovlarni qayta ishlashga ulgurmasa ishlatiladi. Yosh saytlarda Crawl-delay direktivasidan foydalanmaslik yaxshiroqdir. Bu shunday yozilgan:

Foydalanuvchi-agent: Yandex

Tekshirish kechikishi: 4

Clean-param - faqat Yandex tomonidan qo'llab-quvvatlanadi va o'zgaruvchilar bilan ikki nusxadagi sahifalarni yo'q qilish, ularni bittaga birlashtirish uchun ishlatiladi. Shunday qilib, Yandex roboti shunga o'xshash sahifalarni ko'p marta yuklab olmaydi, masalan, havolalar bilan bog'liq. Men bu direktivani hali ishlatmadim, lekin Yandex uchun robots.txt-dagi yordamda maqolaning boshidagi havolaga o'ting, siz ushbu direktivani batafsil o'qishingiz mumkin.

Maxsus belgilar * va $ robots.txt da "Ruxsat berish" va "Ruxsat berish" direktivalari yo'llarini ko'rsatish uchun ishlatiladi:

- Maxsus belgi "*" har qanday belgilar ketma-ketligini bildiradi. Misol uchun, Disallow: /*?* bu belgidan oldin va keyin qaysi belgilar kelishidan qat'iy nazar, manzilda “?” ko'rsatilgan har qanday sahifalarni taqiqlashni anglatadi. Odatiy bo'lib, har bir qoidaning oxiriga maxsus belgi "*" qo'shiladi, hatto u aniq ko'rsatilmagan bo'lsa ham.

- "$" belgisi qoida oxiridagi "*" belgisini bekor qiladi va qat'iy muvofiqlikni bildiradi. Masalan, Disallow: /*?$ direktivasi “?” belgisi bilan tugaydigan sahifalarni indekslashni taqiqlaydi.

WordPress uchun misol robots.txt

WordPress dvigatelidagi blog uchun mening robots.txt faylimga misol:

| User-agent: * Ruxsat berish: /cgi-bin Ruxsat berish: /wp-admin Ruxsat berish: /wp-includes Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Ruxsat bermaslik: / trackback Ruxsat berish: */trackback Ruxsat berish: */*/trackback Ruxsat berish: /feed/ Ruxsat berish: */*/feed/*/ Ruxsat berish: */feed Ruxsat berish: /*?* Ruxsat berish: /?s= Foydalanuvchi-agent: Yandex Ruxsat berish: /cgi-bin Ruxsat berish: /wp-admin Ruxsat berish: /wp-includes Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Ruxsat berish: /trackback Ruxsat berish: */ trackback Ruxsat berish: */*/trackback Ruxsat berish: /feed/ Ruxsat berish: */*/feed/*/ Ruxsat berish: */feed Ruxsat berish: /*?* Ruxsat berish: /?.ru/sitemap.xml..xml |

User-agent: * Ruxsat berish: /cgi-bin Ruxsat berish: /wp-admin Ruxsat berish: /wp-includes Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Ruxsat bermaslik: / trackback Ruxsat berish: */trackback Ruxsat berish: */*/trackback Ruxsat berish: /feed/ Ruxsat berish: */*/feed/*/ Ruxsat berish: */feed Ruxsat berish: /*?* Ruxsat berish: /?s= Foydalanuvchi-agent: Yandex Ruxsat berish: /cgi-bin Ruxsat berish: /wp-admin Ruxsat berish: /wp-includes Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Ruxsat berish: /trackback Ruxsat berish: */ trackback Ruxsat berish: */*/trackback Ruxsat berish: /feed/ Ruxsat berish: */*/feed/*/ Ruxsat berish: */feed Ruxsat berish: /*?* Ruxsat berish: /?.ru/sitemap.xml..xml

WordPress uchun to'g'ri robots.txt yaratish bilan o'zingizni aldamaslik uchun ushbu fayldan foydalanishingiz mumkin. Indekslash bilan bog'liq muammolar yo'q. Menda nusxa ko'chirishdan himoya qilish skripti bor, shuning uchun tayyor robots.txt faylini yuklab olish va uni hostingingizga yuklash qulayroq bo'ladi. Xost va Sayt xaritasi ko'rsatmalarida mening saytim nomini sizniki bilan almashtirishni unutmang.

WordPress uchun robots.txt faylini to'g'ri sozlash uchun foydali qo'shimchalar

Agar daraxt sharhlari WordPress blogingizga o'rnatilgan bo'lsa, ular ?replytocom= shaklidagi dublikat sahifalarni yaratadilar. robots.txt da bunday sahifalar Disallow: /*?* direktivasi bilan yopiladi. Ammo bu yechim emas va taqiqlarni olib tashlash va replytocom bilan boshqa yo'l bilan kurashish yaxshiroqdir. Nima, .

Shunday qilib, 2014 yil iyul holatiga ko'ra joriy robots.txt quyidagicha ko'rinadi:

| User-agent: * Ruxsat berish: /wp-includes Ruxsat berish: /wp-feed Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Foydalanuvchi agenti: Yandex Ruxsat berish: /wp -o'z ichiga oladi Ruxsat berish: /wp-feed Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Xost: site.ru Foydalanuvchi-agent: Googlebot-Image Ruxsat berish: /wp-content /uploads/ User-agent: YandexImages Ruxsat: /wp-content/uploads/ Sayt xaritasi: http://site.ru/sitemap.xml |

User-agent: * Ruxsat berish: /wp-includes Ruxsat berish: /wp-feed Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Foydalanuvchi agenti: Yandex Ruxsat berish: /wp -o'z ichiga oladi Ruxsat berish: /wp-feed Ruxsat berish: /wp-content/plugins Ruxsat berish: /wp-content/cache Ruxsat berish: /wp-content/themes Xost: site.ru Foydalanuvchi-agent: Googlebot-Image Ruxsat berish: /wp-content /uploads/ User-agent: YandexImages Ruxsat: /wp-content/uploads/ Sayt xaritasi: http://site.ru/sitemap.xml

U qo'shimcha ravishda tasvirni indekslash robotlari uchun qoidalarni belgilaydi.

Foydalanuvchi-agent: Mediapartners-Google

Ruxsat bermaslik:

Agar siz toifa yoki teg sahifalarini targ'ib qilishni rejalashtirmoqchi bo'lsangiz, ularni robotlarga ochishingiz kerak. Misol uchun, blog veb-saytida toifalar indeksatsiyadan yopilmaydi, chunki ular faqat maqolalarning kichik e'lonlarini nashr etadilar, bu kontentni takrorlash nuqtai nazaridan juda ahamiyatsiz. Va agar siz noyob e'lonlar bilan to'ldirilgan blog tasmasida tirnoqlarni ko'rsatishdan foydalansangiz, unda hech qanday takrorlash bo'lmaydi.

Yuqoridagi plagindan foydalanmasangiz, robots.txt faylida teglar, toifalar va arxivlarni indekslashni taqiqlashni belgilashingiz mumkin. Masalan, quyidagi qatorlarni qo'shish:

Ruxsat bermaslik: /muallif/

Ruxsat bermaslik: / teg

Ruxsat bermaslik: /category/*/*

Ruxsat bermaslik: /20*

Yandex.Webmaster panelida robots.txt faylini tekshirishni unutmang va keyin uni xostingingizga qayta yuklang.

Agar sizda robots.txt ni sozlash uchun qo'shimchalaringiz bo'lsa, bu haqda sharhlarda yozing. Endi bu nima va sayt uchun to'g'ri robots.txt faylini qanday yaratish, robots.txt faylida indekslashni qanday taqiqlash va xatolarni tuzatish haqida videoni tomosha qiling.

robots.txt fayli saytingizning asosiy katalogida joylashgan. Masalan, www.example.com saytida robots.txt fayl manzili www.example.com/robots.txt kabi ko'rinadi. robots.txt fayli oddiy matnli fayl bo'lib, robotni istisno qilish standartiga amal qiladi va bir yoki bir nechta qoidalarni o'z ichiga oladi, ularning har biri ma'lum bir brauzerga saytdagi muayyan yo'lga kirishni rad etadi yoki ruxsat beradi.

Quyida ikkita qoidaga ega oddiy robots.txt fayliga misol keltirilgan. Quyida tushuntirishlar keltirilgan.

# 1-guruh foydalanuvchi-agenti: Googlebot Ruxsat bermaslik: /nogooglebot/ # 2-guruh foydalanuvchi-agenti: * Ruxsat berish: / Sayt xaritasi: http://www.example.com/sitemap.xml

Tushuntirishlar

- Googlebot deb nomlangan foydalanuvchi agenti http://example.com/nogooglebot/ katalogini va uning quyi kataloglarini tekshirmasligi kerak.

- Boshqa barcha foydalanuvchi agentlari butun saytga kirish huquqiga ega (o'tkazib yuborilishi mumkin, natija bir xil bo'ladi, chunki to'liq kirish sukut bo'yicha beriladi).

- Sayt xaritasi fayli bu sayt http://www.example.com/sitemap.xml manzilida joylashgan.

Quyida robots.txt fayllari bilan ishlash bo'yicha ba'zi maslahatlar mavjud. Ushbu fayllarning to'liq sintaksisini o'rganishingizni tavsiya qilamiz, chunki ularni yaratishda ishlatiladigan sintaksis qoidalari aniq emas va siz ularni tushunishingiz kerak.

Format va tartib

UTF-8 kodlashni qo'llab-quvvatlaydigan deyarli har qanday matn muharririda robots.txt faylini yaratishingiz mumkin. Matn protsessorlaridan foydalanmang, chunki ular ko'pincha fayllarni xususiy formatda saqlaydi va qidiruv robotlari tomonidan tan olinmaydigan jingalak tirnoq kabi noto'g'ri belgilar qo'shadi.

robots.txt fayllarini yaratish va sinovdan o'tkazishda sinov vositasidan foydalaning. Bu sizga fayl sintaksisini tahlil qilish va uning saytingizda qanday ishlashini aniqlash imkonini beradi.

Fayl formati va joylashuviga oid qoidalar

- Fayl robots.txt deb nomlanishi kerak.

- Saytda faqat bitta fayl bo'lishi kerak.

- robots.txt fayli joylashtirilishi kerak ildiz katalogi sayt. Masalan, http://www.example.com/ saytidagi barcha sahifalarni skanerlashni boshqarish uchun robots.txt fayli http://www.example.com/robots.txt manzilida joylashgan bo'lishi kerak. U pastki katalogda bo'lmasligi kerak(masalan, manzilda http://example.com/pages/robots.txt). Agar siz ildiz katalogiga kirishda qiynalsangiz, hosting provayderingizga murojaat qiling. Agar saytning asosiy katalogiga kirish imkoningiz bo'lmasa, meta teglar kabi muqobil blokirovka usulidan foydalaning.

- robots.txt fayli manzillarga qo'shilishi mumkin subdomenlar(masalan, http:// veb-sayt.example.com/robots.txt) yoki nostandart portlar (masalan, http://example.com: 8181 /robots.txt).

- # belgisidan keyingi har qanday matn izoh hisoblanadi.

Sintaksis

- robots.txt fayli UTF-8 da kodlangan matn fayli bo'lishi kerak (bu ASCII belgilar kodlarini o'z ichiga oladi). Boshqa belgilar toʻplamidan foydalanib boʻlmaydi.

- robots.txt fayli quyidagilardan iborat guruhlar.

- Har biri guruh bir nechtasini o'z ichiga olishi mumkin qoidalar, har bir satrda bittadan. Ushbu qoidalar ham deyiladi direktivalar.

- Guruh quyidagi ma'lumotlarni o'z ichiga oladi:

- qaysiga foydalanuvchi agenti Guruh ko'rsatmalari qo'llaniladi.

- kirish huquqiga ega.

- Bu agent qaysi katalog yoki fayllarga kira oladi? Kirish yo'q.

- Guruh ko'rsatmalari yuqoridan pastgacha o'qiladi. Robot unga eng mos keladigan foydalanuvchi agenti bilan faqat bitta guruh qoidalariga amal qiladi.

- Odatiy bo'lib, u taxmin qilinadi Agar sahifa yoki katalogga kirish Disallow: qoidasi bilan bloklanmagan bo'lsa, foydalanuvchi agenti uni qayta ishlashi mumkin.

- Qoidalar harflar katta-kichikligiga sezgir. Shunday qilib, ruxsat bermaslik: /file.asp qoidasi http://www.example.com/file.asp URL manzili uchun amal qiladi, lekin http://www.example.com/File.asp uchun emas.

robots.txt fayllarida ishlatiladigan direktivalar

- Foydalanuvchi-agent: Majburiy ko'rsatma, bir guruhda ulardan bir nechtasi bo'lishi mumkin. Qaysi qidiruv tizimini aniqlaydi robot qoidalar amal qilishi kerak. Har bir guruh shu qatordan boshlanadi. Googlebots bilan bog'liq ko'pchilik foydalanuvchi agentlarini maxsus ro'yxatda va Internet Robotlar ma'lumotlar bazasida topish mumkin. Prefiks, yoʻl qoʻshimchasi yoki butun yoʻlni koʻrsatish uchun * joker belgisi qoʻllab-quvvatlanadi. Barcha brauzerlarga kirishni bloklash uchun quyidagi misolda ko'rsatilganidek * belgisidan foydalaning ( AdsBot robotlaridan tashqari, bu alohida ko'rsatilishi kerak). Google robotlari ro'yxati bilan tanishib chiqishingizni tavsiya qilamiz. Misollar:# Misol 1. Faqat Googlebot foydalanuvchi agentiga kirishni bloklash: Googlebot Disallow: / # Misol 2. Googlebot va AdsBot robotlariga kirishni bloklash Foydalanuvchi-agent: Googlebot User-agent: AdsBot-Google Disallow: / # 3-misol. AdsBot User-agentdan tashqari barcha robotlar: * Ruxsat bermaslik: /

- Ruxsat bermaslik: . Yuqorida belgilangan foydalanuvchi agenti tomonidan tekshirib bo'lmaydigan ildiz domeniga oid katalog yoki sahifaga ishora qiladi. Agar bu sahifa bo'lsa, brauzerning manzil satridagi kabi unga to'liq yo'l ko'rsatilishi kerak. Agar bu katalog bo'lsa, yo'l slash (/) bilan tugashi kerak. Prefiks, yoʻl qoʻshimchasi yoki butun yoʻlni koʻrsatish uchun * joker belgisi qoʻllab-quvvatlanadi.

- Ruxsat bering: Har bir guruhda kamida bitta Disallow: yoki Allow: direktivasi bo'lishi kerak. Yuqorida belgilangan foydalanuvchi agenti tomonidan tekshirilishi mumkin bo'lgan ildiz domeniga oid katalog yoki sahifaga ishora qiladi. Disallow direktivasini bekor qilish va skanerlash uchun yopilgan katalogdagi kichik katalog yoki sahifani skanerlashga ruxsat berish uchun foydalaniladi. Agar bu sahifa bo'lsa, brauzerning manzil satrida bo'lgani kabi, unga to'liq yo'l ko'rsatilishi kerak. Agar bu katalog bo'lsa, yo'l slash (/) bilan tugashi kerak. Prefiks, yoʻl qoʻshimchasi yoki butun yoʻlni koʻrsatish uchun * joker belgisi qoʻllab-quvvatlanadi.

- Sayt xaritasi: Ixtiyoriy direktiv faylda ulardan bir nechtasi bo'lishi yoki hech biri bo'lmasligi mumkin. Ushbu saytda ishlatiladigan sayt xaritasining joylashuvini ko'rsatadi. URL to'liq bo'lishi kerak. Google http va https prefikslari yoki www elementi bilan yoki bo'lmasdan URL o'zgarishlarini qayta ishlamaydi yoki tasdiqlamaydi. Sayt xaritalari Google-ga qanday tarkibni bildiradi kerak skanerlash va uni tarkibdan qanday ajratish mumkin mumkin yoki bu taqiqlangan skanerlash. Misol: Sayt xaritasi: https://example.com/sitemap.xml Sayt xaritasi: http://www.example.com/sitemap.xml

Boshqa qoidalar e'tiborga olinmaydi.

Yana bir misol

robots.txt fayli guruhlardan iborat. Ularning har biri qoidalarga rioya qilishi kerak bo'lgan robotni belgilaydigan User-agent qatoridan boshlanadi. Quyida ikkita guruh va ikkalasi uchun izohli izohlar mavjud fayl misoli keltirilgan.

# Googlebotning example.com/directory1/... va example.com/directory2/... ga kirishini bloklash # lekin directory2/subdirectory1/... ga kirishga ruxsat bering # Boshqa barcha kataloglarga sukut bo'yicha ruxsat beriladi. User-agent: googlebot Ruxsat berish: /directory1/ Ruxsat berish: /directory2/ Ruxsat berish: /directory2/subdirectory1/ # Boshqa qidiruv tizimiga butun saytga kirishni bloklash. Foydalanuvchi-agent: anothercrawler Ruxsat bermaslik: /

robots.txt faylining to'liq sintaksisi

To'liq sintaksis ushbu maqolada tasvirlangan. U bilan tanishib chiqishingizni tavsiya qilamiz, chunki robots.txt fayli sintaksisida muhim nuanslar mavjud.

Foydali qoidalar

Robots.txt fayli uchun ba'zi umumiy qoidalar:

| Qoida | Misol |

|---|---|

| Butun saytni skanerlashni taqiqlash. Shuni esda tutingki, ba'zi hollarda sayt URL manzillari skanerdan o'tkazilmagan bo'lsa ham indeksda bo'lishi mumkin. E'tibor bering, ushbu qoida alohida ko'rsatilishi kerak bo'lgan AdsBot robotlariga taalluqli emas. | Foydalanuvchi-agent: * Ruxsat bermaslik: / |

| Katalog va uning barcha mazmunini skanerlashni oldini olish uchun, katalog nomidan keyin qiyshiq chiziq qo'ying. Maxfiy ma'lumotlarni himoya qilish uchun robots.txt faylidan foydalanmang! Ushbu maqsadlar uchun autentifikatsiyadan foydalanish kerak. robots.txt fayli tomonidan skanerlanishiga ruxsat berilmagan URL-manzillar indekslanishi va robots.txt faylining mazmunini istalgan foydalanuvchi ko'rishi va shu tariqa nozik ma'lumotlarga ega fayllarning joylashuvini aniqlashi mumkin. | Foydalanuvchi-agent: * Ruxsat bermaslik: /kalendar/ Ruxsat bermaslik: /junk/ |

| Faqat bitta brauzer tomonidan skanerlashga ruxsat berish | Foydalanuvchi-agent: Googlebot-news Ruxsat berish: / Foydalanuvchi-agent: * Ruxsat bermaslik: / |

| Bittasidan tashqari barcha brauzerlar uchun skanerlashga ruxsat berish | Foydalanuvchi-agent: Unnecessarybot Ruxsat berish: / Foydalanuvchi-agent: * Ruxsat berish: / |

|

Muayyan sahifani tekshirilishining oldini olish uchun, qiyshiq chiziqdan keyin ushbu sahifani belgilang. |

Foydalanuvchi-agent: * Ruxsat bermaslik: /private_file.html |

|

Google Images robotidan ma'lum bir tasvirni yashirish uchun |

Foydalanuvchi-agent: Googlebot-Image ruxsat bermaslik: /images/dogs.jpg |

|

Saytingizdagi barcha rasmlarni Google Images robotidan yashirish uchun |

Foydalanuvchi-agent: Googlebot-Image Disallow: / |

|

Muayyan turdagi barcha fayllarni skanerlashning oldini olish uchun(bu holda GIF) |

Foydalanuvchi-agent: Googlebot Ruxsat bermaslik: /*.gif$ |

|

Saytingizdagi ayrim sahifalarni bloklash, lekin ularda AdSense reklamalarini ko‘rsatish, Mediapartners-Googledan tashqari barcha robotlar uchun Ruxsat berish qoidasidan foydalaning. Natijada, ushbu robot ma'lum bir foydalanuvchiga ko'rsatish uchun reklamalarni tanlash uchun qidiruv natijalaridan olib tashlangan sahifalarga kira oladi. |

Foydalanuvchi-agent: * Ruxsat bermaslik: / Foydalanuvchi-agent: Mediapartners-Google Ruxsat berish: / |

| Muayyan fragmentda tugaydigan URL manzilini belgilash uchun, $ belgisidan foydalaning. Masalan, .xls bilan tugaydigan URL manzillar uchun quyidagi koddan foydalaning: | Foydalanuvchi-agent: Googlebot Ruxsat bermaslik: /*.xls$ |

Ushbu ma'lumot foydali bo'ldimi?

Ushbu maqolani qanday yaxshilash mumkin?

Qidiruv tizimlari uchun veb-saytni optimallashtirish bosqichlaridan biri robots.txt faylini kompilyatsiya qilishdir. Ushbu fayldan foydalanib, siz ba'zi yoki barcha qidiruv robotlarining saytingizni yoki uning indekslash uchun mo'ljallanmagan ayrim qismlarini indekslashiga yo'l qo'ymasligingiz mumkin. Xususan, sahifalarning chop etiladigan versiyalari kabi ikki nusxadagi tarkibni indeksatsiya qilinishini oldini olishingiz mumkin.

Indekslashni boshlashdan oldin qidiruv robotlari har doim saytingizning asosiy katalogidagi robots.txt fayliga murojaat qiladi, masalan, http://site.ru/robots.txt, robot saytning qaysi bo'limlari taqiqlanganligini bilish uchun. indekslashdan. Ammo siz hech narsani taqiqlamoqchi bo'lmasangiz ham, ushbu faylni yaratish tavsiya etiladi.

Robots.txt kengaytmasidan ko'rib turganingizdek, bu matnli fayl. Ushbu faylni yaratish yoki tahrirlash uchun Notepad kabi eng oddiy matn muharrirlaridan foydalanish yaxshidir. robots.txt saytning asosiy katalogiga joylashtirilishi va o'z formatiga ega bo'lishi kerak, biz quyida muhokama qilamiz.

Robots.txt fayl formati

robots.txt faylida kamida ikkita talab qilinadigan yozuv boʻlishi kerak. Birinchisi, qaysi qidiruv roboti keyingi ko'rsatmalarga amal qilishi kerakligini ko'rsatadigan User-agent direktivasi. Qiymat robotning nomi (googlebot, Yandex, StackRambler) yoki barcha robotlarga bir vaqtning o'zida kirayotgan bo'lsangiz * belgisi bo'lishi mumkin. Masalan:

Foydalanuvchi-agent: googlebotSiz robotning nomini tegishli qidiruv tizimining veb-saytida topishingiz mumkin. Keyin bir yoki bir nechta ruxsat berish ko'rsatmalari bo'lishi kerak. Ushbu ko'rsatmalar robotga qaysi fayl va papkalarni indekslashga ruxsat berilmasligini aytadi. Masalan, quyidagi qatorlar robotlarning feedback.php fayli va cgi-bin katalogini indekslashiga to'sqinlik qiladi:

Ruxsat bermaslik: /feedback.php Ruxsat bermaslik: /cgi-bin/Bundan tashqari, siz faqat fayl yoki papkaning boshlang'ich belgilaridan foydalanishingiz mumkin. Disallow: /forum qatori nomi forum bilan boshlanadigan saytning ildizidagi barcha fayl va papkalarni indekslashni taqiqlaydi, masalan, http://site.ru/forum.php fayli va http://site papkasi. ru/forum/ barcha mazmuni bilan. Agar ruxsat bermaslik bo'sh bo'lsa, bu robot barcha sahifalarni indekslashi mumkinligini anglatadi. Agar Disallow qiymati / belgisi bo'lsa, bu butun saytni indeksatsiya qilish taqiqlanganligini anglatadi.

Har bir User-agent maydoni uchun kamida bitta ruxsat berish maydoni bo'lishi kerak. Ya'ni, agar siz indekslash uchun biror narsani taqiqlamoqchi bo'lmasangiz, robots.txt faylida quyidagi yozuvlar bo'lishi kerak:

Foydalanuvchi-agent: * Ruxsat bermaslik:Qo'shimcha direktivalar

Oddiy iboralarga qo'shimcha ravishda, Yandex va Google "Ruxsat berish" direktivasidan foydalanishga ruxsat beradi, bu "Dallow" ning teskarisidir, ya'ni qaysi sahifalarni indekslash mumkinligini ko'rsatadi. Quyidagi misolda Yandex-ga /articles bilan boshlanadigan sahifa manzillaridan tashqari hamma narsani indekslash taqiqlangan:

Foydalanuvchi-agent: Yandex Ruxsat berish: /maqolalar Ruxsat berish: /Ushbu misolda "Ruxsat berish" direktivasi "Ruxsat berish" dan oldin yozilishi kerak, aks holda Yandex buni saytni indekslashni to'liq taqiqlash deb tushunadi. Bo'sh Allow direktivasi saytni indekslashni ham butunlay o'chirib qo'yadi:

Foydalanuvchi-agent: Yandex Ruxsat beradi:ekvivalent

Foydalanuvchi-agent: Yandex taqiqlash: /Nostandart ko'rsatmalar faqat ularni qo'llab-quvvatlaydigan qidiruv tizimlari uchun ko'rsatilishi kerak. Aks holda, ushbu yozuvni tushunmaydigan robot uni yoki butun robots.txt faylini noto'g'ri qayta ishlashi mumkin. Qo'shimcha direktivalar va umuman robots.txt faylidagi buyruqlarni individual robot tomonidan tushunish haqida batafsil ma'lumotni tegishli qidiruv tizimining veb-saytida topish mumkin.

robots.txt faylidagi oddiy ifodalar

Ko'pgina qidiruv tizimlari faqat aniq ko'rsatilgan fayl va papka nomlarini hisobga oladi, ammo yanada rivojlangan qidiruv tizimlari ham mavjud. Google Robot va Yandex Robot robots.txt faylida oddiy oddiy iboralardan foydalanishni qo'llab-quvvatlaydi, bu esa veb-ustalar uchun ish hajmini sezilarli darajada kamaytiradi. Masalan, quyidagi buyruqlar Googlebot-ga .pdf kengaytmali barcha fayllarni indekslashdan saqlaydi:

Foydalanuvchi-agent: googlebot Ruxsat bermaslik: *.pdf$Yuqoridagi misolda * har qanday belgilar ketma-ketligi, $ esa havolaning oxirini bildiradi.

Foydalanuvchi-agent: Yandex Allow: /maqolalar/*.html$ Ruxsat bermaslik: /Yuqoridagi ko'rsatmalar Yandex-ga faqat /articles/ papkasida joylashgan ".html" kengaytmali fayllarni indekslash imkonini beradi. Qolgan hamma narsa indeksatsiya qilish uchun taqiqlangan.

Sayt xaritasi

XML sayt xaritasining joylashuvini robots.txt faylida belgilashingiz mumkin:

Foydalanuvchi-agent: googlebot Ruxsat bermaslik: Sayt xaritasi: http://site.ru/sitemap.xmlAgar sizning saytingizda juda ko'p sahifalar mavjud bo'lsa va siz sayt xaritasini qismlarga bo'lishingiz kerak bo'lsa, robots.txt faylida xaritaning barcha qismlarini ko'rsatishingiz kerak:

Foydalanuvchi-agent: Yandex taqiqlash: Sayt xaritasi: http://mysite.ru/my_sitemaps1.xml Sayt xaritasi: http://mysite.ru/my_sitemaps2.xmlSayt oynalari

Ma'lumki, odatda bir xil saytga ikkita manzilda kirish mumkin: www bilan ham, unsiz ham. Qidiruv roboti uchun site.ru va www.site.ru turli saytlardir, lekin bir xil tarkibga ega. Ular oynalar deb ataladi.

Sayt sahifalariga www bilan ham, wwwsiz ham havolalar mavjudligi sababli, sahifalarning og'irligini www.site.ru va site.ru o'rtasida taqsimlash mumkin. Buning oldini olish uchun qidiruv tizimi saytning asosiy oynasini ko'rsatishi kerak. "Yopishtirish" natijasida barcha vazn bitta asosiy oynaga tegishli bo'ladi va sayt qidiruv natijalarida yuqori o'rinni egallashi mumkin bo'ladi.

Yandex uchun asosiy oynani to'g'ridan-to'g'ri robots.txt faylida Host direktivasi yordamida belgilashingiz mumkin:

Foydalanuvchi-agent: Yandex taqiqlash: /feedback.php Taqiqlash: /cgi-bin/ Xost: www.site.ruYelimlashdan so'ng, www.site.ru oynasi barcha vaznga ega bo'ladi va u qidiruv natijalarida yuqori o'rinni egallaydi. Va qidiruv tizimi site.ru saytini umuman indekslamaydi.

Boshqa qidiruv tizimlari uchun asosiy oynani tanlash qo'shimcha nometalllardan asosiysiga server tomonidan doimiy yo'naltirish (kod 301) hisoblanadi. Bu .htaccess fayli va mod_rewrite moduli yordamida amalga oshiriladi. Buning uchun .htaccess faylini saytning ildiziga qo'ying va u erga quyidagilarni yozing:

RewriteEngine On Options +FollowSymlinks RewriteBase / RewriteCond %(HTTP_HOST) ^site.ru$ RewriteRule ^(.*)$ http://www.site.ru/$1Natijada, site.ru dan barcha so'rovlar www.site.ru saytiga o'tadi, ya'ni site.ru/page1.php www.site.ru/page1.php saytiga yo'naltiriladi.

Qayta yo'naltirish usuli barcha qidiruv tizimlari va brauzerlar uchun ishlaydi, ammo shunga qaramay Yandex uchun robots.txt fayliga Host direktivasini qo'shish tavsiya etiladi.

robots.txt-dagi sharhlar

Shuningdek, siz robots.txt fayliga sharhlar qo'shishingiz mumkin - ular # belgisi bilan boshlanadi va yangi qator bilan tugaydi. Izohlarni alohida satrga yozish tavsiya etiladi yoki ulardan umuman foydalanmaslik yaxshiroqdir.

Sharhlardan foydalanishga misol:

User-agent: StackRambler Disallow: /garbage/ # bu jildda hech qanday foydali narsa yo'q. Ruxsat berish: /doc.xhtml # va bu sahifada ham # va bu fayldagi barcha izohlar ham foydasiz.robots.txt fayllariga misollar

1. Barcha robotlarga barcha sayt hujjatlarini indekslashiga ruxsat bering:

Foydalanuvchi-agent: * Ruxsat bermaslik:Foydalanuvchi-agent: * Ruxsat bermaslik: /

3. Google qidiruv robotiga feedback.php fayli va cgi-bin katalogi tarkibini indekslashni taqiqlaymiz:

Foydalanuvchi-agent: googlebot Ruxsat bermaslik: /cgi-bin/ Ruxsat bermaslik: /feedback.php4. Biz barcha robotlarga butun saytni indekslashiga ruxsat beramiz va Yandex qidiruv tizimi robotiga feedback.php faylini va cgi-bin katalogi tarkibini indekslashni taqiqlaymiz:

Foydalanuvchi-agent: Yandex Taqiqlash: /cgi-bin/ Taqiqlash: /feedback.php Xost: www.site.ru Foydalanuvchi-agent: * Ruxsat bermaslik:5. Biz barcha robotlarga butun saytni indekslashiga ruxsat beramiz va Yandex robotiga saytning faqat unga moʻljallangan qismini indekslashiga ruxsat beramiz:

Foydalanuvchi-agent: Yandex Ruxsat berish: /yandex Ruxsat berish: / Xost: www.site.ru Foydalanuvchi-agent: * Ruxsat berish:Bo'sh chiziqlar turli robotlar uchun cheklovlarni ajratib turadi. Cheklovlarning har bir bloki ushbu saytni indekslash qoidalari qo'llaniladigan robotni ko'rsatuvchi User-Agent maydoniga ega bo'lgan chiziqdan boshlanishi kerak.

Umumiy xatolar

Robots.txt faylidagi bo'sh qator turli robotlar uchun ikkita yozuvni ajratuvchi ekanligini hisobga olish kerak. Bundan tashqari, bir qatorda bir nechta direktivani belgilay olmaysiz. Faylning indekslanishiga yo'l qo'ymaslik uchun veb-ustalar ko'pincha fayl nomidan oldin / ni o'tkazib yuboradilar.

Robots.txt-da saytni to'liq yuklab olish uchun mo'ljallangan turli dasturlar, masalan, TeleportPro uchun saytni indekslashni taqiqlashni ko'rsatishning hojati yo'q. Na yuklab olish dasturlari, na brauzerlar ushbu faylga hech qachon qaramaydi va u erda yozilgan ko'rsatmalarni bajarmaydi. U faqat qidiruv tizimlari uchun mo'ljallangan. Shuningdek, siz robots.txt-da saytingizning administrator panelini bloklamasligingiz kerak, chunki agar biron bir joyda unga havola bo'lmasa, u indekslanmaydi. Siz faqat administrator hududining joylashuvini bu haqda bilmagan odamlarga ochib berasiz. Shuni ham yodda tutish kerakki, juda katta bo'lgan robots.txt qidiruv tizimi tomonidan e'tiborga olinmasligi mumkin. Agar sizda indekslash uchun mo'ljallanmagan sahifalar juda ko'p bo'lsa, ularni shunchaki saytdan olib tashlash yoki alohida katalogga ko'chirish va ushbu katalogni indekslashni oldini olish yaxshiroqdir.

robots.txt faylida xatolar tekshirilmoqda

Qidiruv mexanizmlari sizning robot faylingizni qanday tushunishini tekshirib ko'ring. Google-ni tekshirish uchun siz Google Webmaster Tools-dan foydalanishingiz mumkin. Agar siz robots.txt faylingiz Yandex tomonidan qanday tushunilishini bilmoqchi bo'lsangiz, Yandex.Webmaster xizmatidan foydalanishingiz mumkin. Bu har qanday xatolarni o'z vaqtida tuzatish imkonini beradi. Shuningdek, ushbu xizmatlar sahifalarida siz robots.txt faylini yaratish bo'yicha tavsiyalar va boshqa foydali ma'lumotlarni topishingiz mumkin.

Maqolani nusxalash taqiqlanadi.